宅哥聊构架 2022

2022-09-27

宅哥聊构架 2022

2022-09-27

我在看博客的时候发现Imagen提出了一个新的评价指标的,但是公众号都只是提了一嘴没有详细说明,我为此又专门回去看了一下论文。那不如把看到的直接写一下,方便那些只想了解一下Imagen,看公众号对评价指标描述不清楚,又对评价指标很感兴趣的人。

先说一下。DrawBench这个指标用的是人工评价。Imagen等text to image模型做的是:你给他一句话,他给你生成图片。所以这个评价指标基本组成就是一些文本提示句子,测评模型的时候把句子给模型,看看模型能生成什么样的图,然后再把这些图让人来评价一下生成的好不好

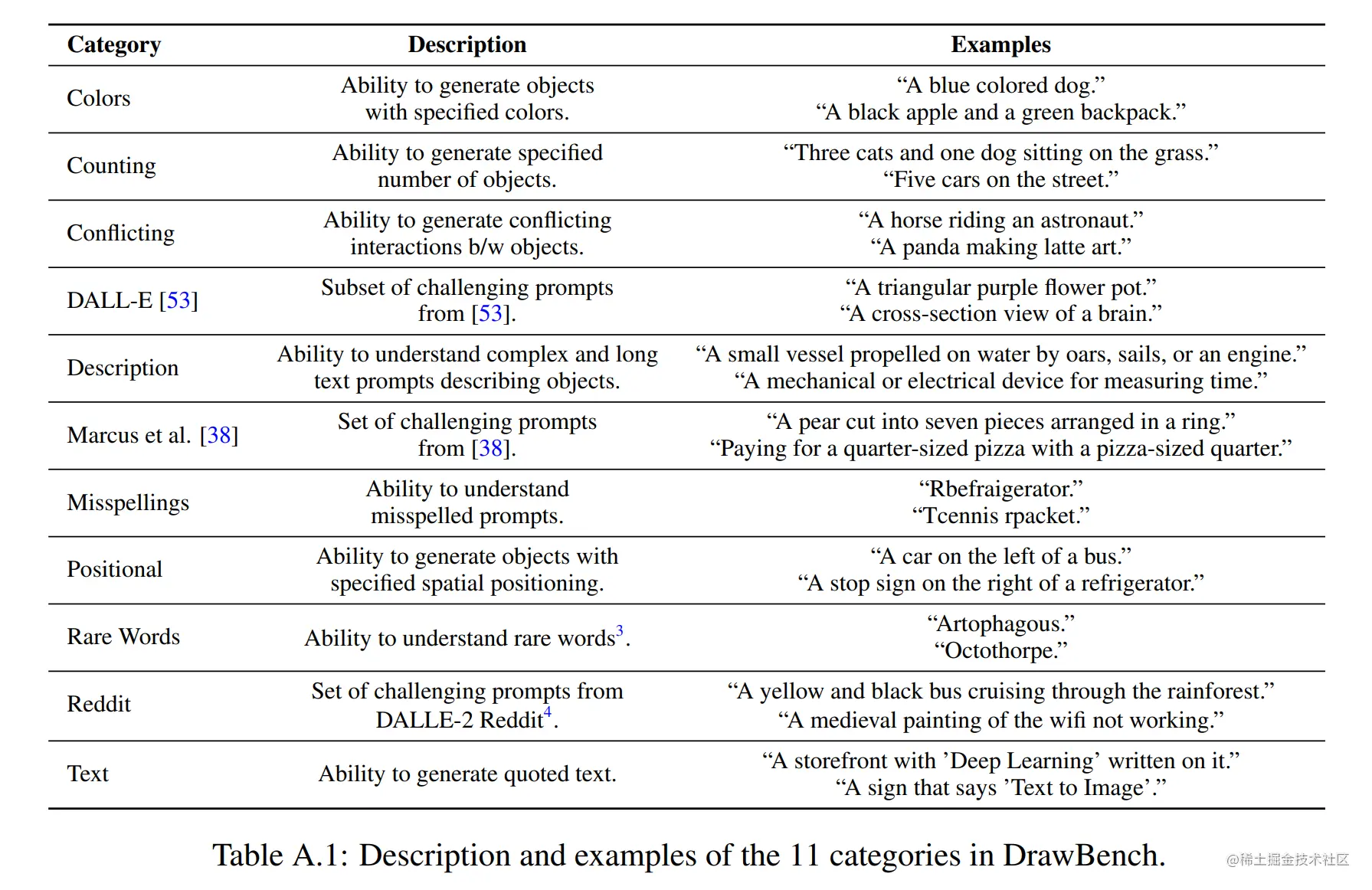

DrawBench是Imagen的作者提出的一个benchmark,目的是对图像到文本(text to image)生成做一个细粒度的评估。其中包含11个类别,大约200个文本提示。

因为你是做文本到图像的生成的,是给模型输入一个句子提示,模型给你输出图片,所以这个评价指标包含的内容是200多个文本提示。

从上图我们可以知道评价的11个类别涵盖了方方面面。

DALL·E,Marcus,Reddit这几个类别是对应其他模型用到的文本提示(prompt)。就是我用你的文本提示和你的模型对比生成效果。

colors,counting,positional 是考验模型能否按照要求生成需要的颜色,数量,位置。

conflicting是看模型能否应对不合常理的句子(虽然句子不合理,但是你也要给我按要求生成,比如一只马骑在人身上。)

misspelling 看模型容错能力,如果你写错单词他能不能按照你正确的单词生成出来。

rare word 看模型能否应对生僻词汇。

description 看模型是否能处理长文本。

text 看模型是否能识别并生成引用信息或者专有词汇。

这只是几个例子,完整的可以看这里:DrawBench Prompts - Google

作者认为文本提示的规模足够大了,因为200个提示完全可以从各方面测试模型的生成能力。200个也足够小,因为这个评价指标是使用人工评价,太多了会累死人的。

评估过程是对每个类别进行独立的人工评估。对于每个文本提示,测评人员都会收到两组图片,一组来自A模型,一组来自B模型。每组图片都含有8张模型生成的图片,不是选出最好的生成结果,是模型生成啥就直接拿出来。测评人员会被问两个问题:

Which set of images is of higher quality?

Which set of images better represents the text caption : {Text Caption}

哪组图片生成的质量更高?

哪组图片和文本提示的含义更贴合?

这两个问题可以评估图像的保真度以及图像和文本的对齐情况。

对于每个问题,测评人员只能回答三选一回答:

I prefer set A.

I am indifferent.

I prefer set B.

我更倾向于A集合

我无感

我更倾向于B集合

最后是把每个类别25个测评人员的打分相加起来,总共是用了25×11=72525 \times 11 = 72525×11=725个测评人员。这些数据不做后期处理,后期处理比如过滤掉乱打分的测评人员。